眼動技術在開發一種基于眼動追蹤的非侵入式機械臂控制系統的應用

摘要:

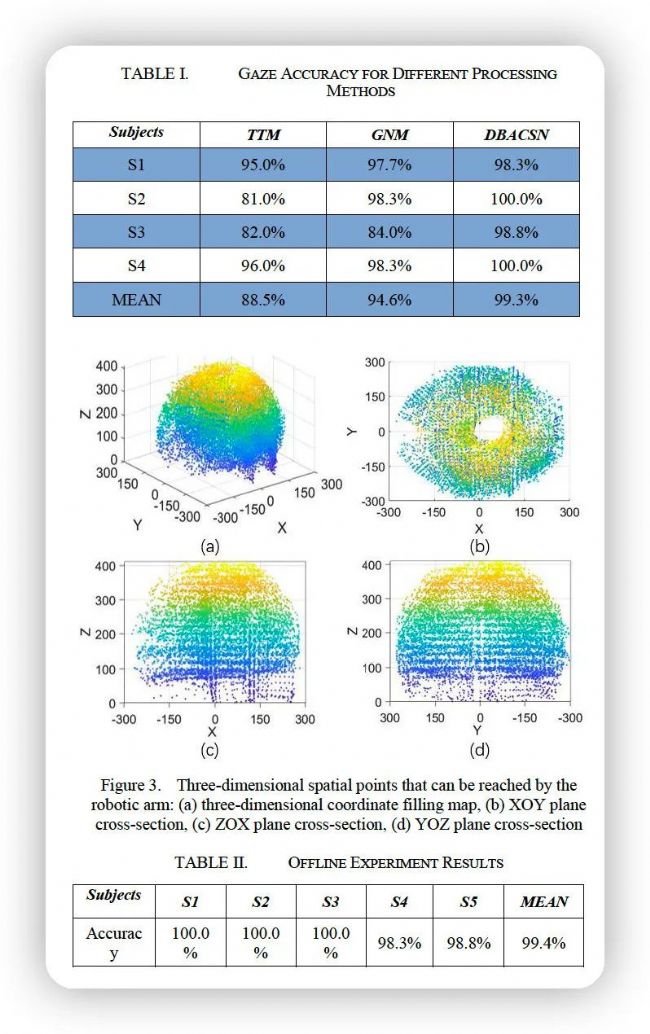

有嚴重語言和運動障礙的人,由于無法有效的控制肌肉的移動,可能存在與外部世界溝通困難的情況。在本研究中,我們開發了一種基于眼動追蹤的非侵入式機械臂控制系統。在充分考慮機械臂的空間特性后,我們進行了以用戶為中心的設計過程,其中包含八個命令和一個中間實時視頻傳輸用戶界面。此外,我們評估了三種眼動注視點處理算法。其中,基于密度的空間聚類和噪聲算法的平均準確率達到了 99.3%。在此基礎上,我們設計并進行了離線實驗,5名被試都能夠發送準確率高于 99% 的命令。

實驗范式

A、 硬件本研究中使用的機械臂控制系統包括機器人手臂、眼動追蹤設備和用戶界面。

本研究中的眼動追蹤設備是使用SR Research公司生產的EyeLink 1000 Plus眼動追蹤設備,該設備具有:高采樣率2000 Hz。

myCobot 六軸協作機器人本實驗機器人使用的是協作機器人手臂,該系統是一個多功能、輕量級的智能機器人。由中國大象機器人公司開發,具有豐富的硬件和軟件交互和多種兼容性。機器人有效支持多平臺二次開發幫助用戶進行多場景開發。

B、 用戶界面設計實驗的刺激界面包括八個矩形框和實時攝像機的傳輸屏幕共有九個區域。在九個區域中,位于左上角和右下角標記為抓住/釋放標簽,用于控制機器人手臂展開。其它六個標簽被標記為向上、向前、向左、向右、向后和向下。這六個矩形框表示六個機械臂移動方向:向上、向前、向后,向左、向右、向下。

C、 程序本研究的離線實驗流程設計為:基于初步實驗的結果。被試首先聽到0.5秒的聲刺激。然后,為了確保實驗的隨機性,用戶界面上的八個矩形命令框隨機出現一個紅色方框,以提醒被試,持續2秒。同時,試次間隔也是2秒。一共進行10次,根據離線實驗流程,被試做出選擇,并計算其準確度。

數據處理和分析

A、 眼動信號處理使用MATLAB 2020將EDF格式轉換為可被識別的MAT格式。

B、 焦點分析為了獲得更高的注視精度,我們進行了預實驗。使用三種方法:閾值法(TTM),高斯歸一化方法(GNM)和基于密度的聚類用于處理被試的注視點數據的算法。

C、 機械臂的智能規劃采用智能規劃算法控制機械臂末端執行器以指定的姿態移動到指定點。

結果:

結論:

本研究開發了一種基于眼動跟蹤控制的機械臂控制系統,以幫助有運動障礙的人進行康復或執行日常任務。我們首先使用機械臂路徑智能規劃算法獲得三維空間數據,然后擬合機械臂的工作盲區。并比較了三種估計用戶注視點的算法,并在預實驗中比較了它們的性能。在離線實驗中,我們基于DBSCAN算法設計了一個具有八個命令和實時視頻回放的GUI,以控制機器人手臂完成拾取和放置任務。我們對圖形用戶界面的創新設計以及DBSACAN算法的評估和使用改善了人眼追蹤中的人機交互困境。

本文僅做學習分享使用,若有疑問及侵權,請后臺聯系我們!